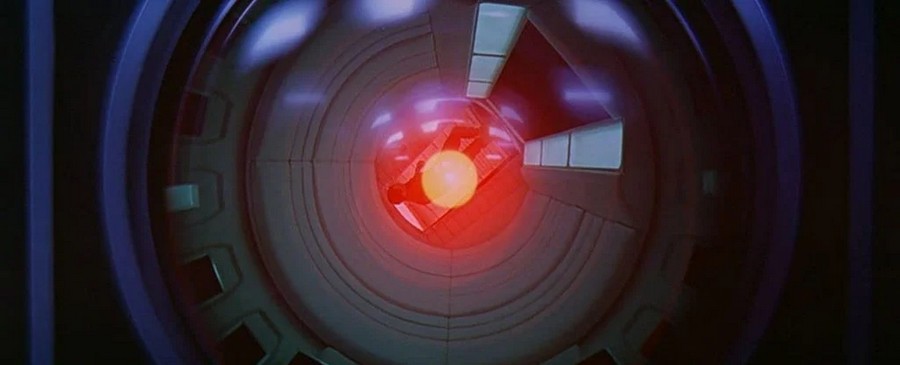

Жасанды интеллекттің адамзатты құлату идеясы ондаған жылдар бойы талқыланып келді және 2021 жылдың қаңтарында ғалымдар жоғары деңгейдегі компьютерлік интеллектті басқара аламыз ба, жоқ па деген қорытынды жасады. Жауап беру? Жоқ дерлік.

Мәселе мынада, адам түсінігінен әлдеқайда жоғары ақыл-ойды басқару үшін біз талдай алатын осы ақыл-ойды модельдеу қажет болады. Бірақ егер біз оны түсіне алмасақ, мұндай симуляцияны жасау мүмкін емес.

Жасанды интеллект (AI) қандай сценарийлер жасайтынын түсінбейінше, «адамға зиян келтірмеу» сияқты ережелерді орнату мүмкін емес, деп есептейді 2021 құжатының авторлары. Компьютерлік жүйе бағдарламашыларымыздың мүмкіндіктерінен асып түсетін деңгейде жұмыс істей бастағанда, біз енді шектеу қоя алмаймыз.

«Суперинтеллект әдетте «робот этикасы» туымен зерттелетін мәселелерден түбегейлі басқа мәселе», - деп жазады зерттеушілер. «Бұл супермидің көп қырлы болғандықтан, сондықтан басқарылатынды былай қойғанда, адамдар үшін мүмкін емес, мүмкін емес мақсаттарға жету үшін әртүрлі ресурстарды жұмылдыру мүмкіндігі бар».

Команданың пайымдауларының бір бөлігі осыдан келеді тоқтату проблемалары, 1936 жылы Алан Тюринг ұсынған. Мәселе компьютерлік бағдарлама қорытындыға келіп, жауап бере ме (және тоқтай ма) немесе жауап табуға тырысып, мәңгілікке тоқтай ма, соны анықтау.

Тьюринг көмегімен дәлелдегендей интеллектуалды математика, біз мұны кейбір нақты бағдарламалар үшін білуіміз мүмкін, бірақ жазуға болатын әрбір әлеуетті бағдарлама үшін мұны білуге мүмкіндік беретін жолды табу логикалық тұрғыдан мүмкін емес. Бұл бізді АИ-ге қайтарады, ол өте интеллектуалды күйде барлық ықтимал компьютерлік бағдарламаларды бір уақытта жадында сақтай алады.

Сондай-ақ қызықты:

- OpenAI жасанды интеллектке командаларды бағдарлама кодына түрлендіруді үйретті

- Жасанды интеллект гравитациялық толқындарды іздейді

Мысалы, AI-ның адамдарға зиянын тигізуін және әлемді жоюын тоқтату үшін жазылған кез келген бағдарлама қорытындыға жетуі мүмкін (және тоқтауы) мүмкін - математикалық тұрғыдан екі жолмен де толық сенімді болу мүмкін емес, яғни оны тежеу мүмкін емес. «Ол негізінен тежеу алгоритмін жарамсыз етеді», - деді Германиядағы Макс Планк адам дамуы институтының компьютер ғалымы Ияд Рахван қаңтарда.

Зерттеушілердің пікірінше, AI этикасын және әлемді жоюға тыйым салуды үйретудің баламасы, оған ешбір алгоритм сенімді бола алмайды, - бұл суперминдтің мүмкіндіктерін шектеу. Мысалы, ол Интернеттің бір бөлігінен немесе белгілі бір желілерден ажыратылуы мүмкін.

Жақында жүргізілген зерттеудің авторлары бұл идеяны да жоққа шығарады, бұл жасанды интеллекттің ауқымын шектейді деп есептейді - олар айтады, егер біз оны адам мүмкіндіктерінен тыс мәселелерді шешу үшін пайдаланбайтын болсақ, онда оны мүлдем жасаудың қажеті не?

Егер біз жасанды интеллектті дамытқымыз келсе, суперинтеллект қашан пайда болатынын білмеуіміз мүмкін, бұл біздің бақылауымыздан тыс, сондықтан оны түсіну мүмкін емес. Бұл дегеніміз, біз қайда баратынымыз туралы маңызды сұрақтар қоя бастауымыз керек.

Макс Планк адам дамуы институтының компьютер ғалымы Мануэль Кебриан: «Әлемді басқаратын өте интеллектуалды машина ғылыми фантастикаға ұқсайды», - дейді. Бірақ кейбір маңызды тапсырмаларды дербес орындайтын машиналар бар, ал бағдарламашылар мұны қалай үйренгенін толық түсінбейді.

Сондықтан ол қандай да бір уақытта бақылаусыз және адамзат үшін қауіпті бола ма деген сұрақ туындайды...

Сондай-ақ оқыңыз:

- Жасанды интеллект Пикассоның боялған картинасын қайта шығара алды

- Жасанды интеллект жол-көлік оқиғаларын олар болғанға дейін болжауға көмектеседі